| IDC:2011年臺灣伺服器市場成長2成 | |||||

| |||||

| 根據IDC調查,去年臺灣伺服器市場成長2成,趨動力來自高科技製造業擴建廠區、政府推動雲端專案與電信媒體擴建IT架構 | |||||

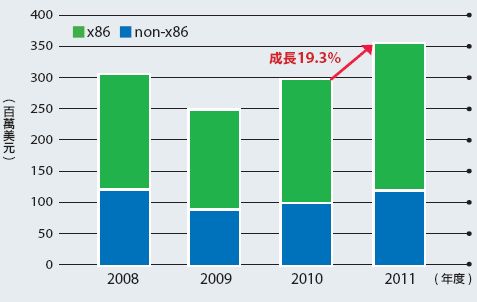

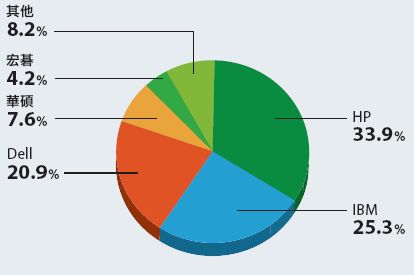

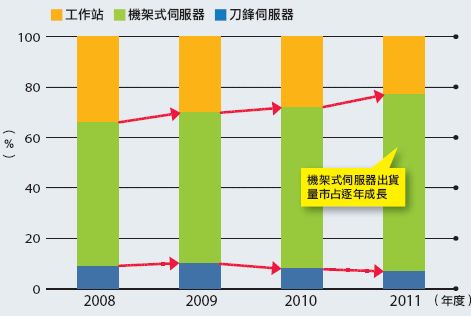

| 臺灣IDC伺服器市場調查報告顯示,2011年臺灣伺服器市場的原廠營收(Factory Revenue)較2010年成長2成,維持從2009年以來的高成長。 臺灣IDC伺服器與儲存市場分析師高振偉表示,去年帶動伺服器市場成長的驅動力來自於政府、高科技與電信媒體等產業。政府的採購專案包括內政部的戶役政資訊系統、財政部電子發票系統、防救災系統等,都趁著雲端計畫而完成建置;不少高科技業者也在去年上半年開始擴建新廠房,像是台積電在南科擴建半導體廠區,到了年底經濟不景氣時,部份的擴建計畫才陸續停擺;多家電信業者建置雲端基礎架構,而媒體業者則是建置網站服務等,這些建置案帶動了去年伺服器市場的採購需求。 以不同的伺服器平臺來看,x86與non-x86市場都較2010年成長將近2成,相較歷年來的成長率,x86市場維持穩定成長,而non-x86市場的成長幅度則比前幾年更高。  一般而言,若檢視x86與non-x86廠商的市占排名,會以出貨量來看x86,以營收來看non-x86。一般而言,x86伺服器基本規格會遵照業界一定的標準,而且各廠牌售價差距不大,如果以營收來看廠牌市占,反而容易受到大量採購的折扣優惠影響,所以出貨量較能反映企業採購x86伺服器的需求。另外,不同類型的non-x86伺服器售價落差懸殊,而且企業單次採購的量也不多,所以較適合透過廠牌營收來觀察企業的需求。 各廠牌在2011年的表現方面,各x86伺服器廠商的出貨量市占排名依序為HP、IBM、Dell、華碩與宏碁。其中HP與Dell都比2010年成長近16%,成長幅度遙遙領先其他廠商,而IBM與華碩僅成長3.7%,宏碁甚至下滑了25%。  高振偉表示,去年HP的客戶來自電信與製造業大規模的建置案,Dell則來自既有的電信、網路服務與部分製造業擴建基礎架構,新增專案則是電子商務平臺的建置需求,這些產業在去年的採購需求很顯著,因而帶動這些廠牌x86出貨量的成長。另外,宏碁去年調整了公司內部的組織人力、產品線與通路,精簡部分的產品線,因而造成出貨量下滑。 至於各non-x86伺服器廠商的營收市占排名依序為IBM、HP、Oracle。相較於2010年,Oracle躍升6成,IBM成長3成,HP卻下滑將近1成。高振偉表示,IBM主要的營收來自既有用戶要汰換大型主機,而不是因為新用戶導入;Oracle在2010年併購昇陽後,在non-x86營收市占下滑3~4成,然而,在去年,除了彌補先前下滑的市占,還因為Oracle推出了整合雙方軟硬體產品的解決方案,獲得市場迴響,因而帶動營收的成長。 進一步來看不同伺服器平臺出貨量的市占率,機架式伺服器突飛猛進,去年的市占高達7成,已在過去4年內增加了13個百分比,工作站與刀鋒伺服器的出貨量市占率為3成,有逐年下滑的態勢,尤其是工作站從2008年的34%市占下滑為2011年的23%。 高振偉指出,機架式伺服器的基本規格已達標準化,在大規模的雲端資料中心當中,便於企業快速部署與汰換設備,同時較能簡化維運管理工作,因而帶動出貨量快速成長。 然而,工作站與刀鋒伺服器偏向專屬的應用環境,如工作站大多用來執行中小企業的小型系統,提供30~50位員工使用,隨著公有雲平臺興起,越來越多中小企業改採公有雲或線上租用服務,來節省自行維運的負擔,因而造成工作站的市占下滑,刀鋒伺服器市占大致持平,由於不同廠牌的刀鋒產品欠缺統一規格,價格也偏高,造成應用較難普及。文⊙鄭逸寧  |

星期四, 4月 26, 2012

IDC:2011年臺灣伺服器市場成長2成 文/鄭逸寧 2012-04-24

星期三, 4月 25, 2012

AMD伺服器平臺處理器 文/林柏凱

| 全面剖析2012 AMD伺服器平臺處理器 | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| AMD去年底推出的Opteron 6200系列與4200系列處理器,核心全面採用新的Bulldozer架構,以6200系列而言,最多內建16核心 | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

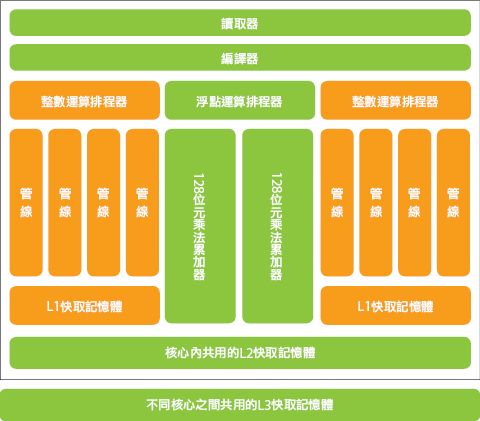

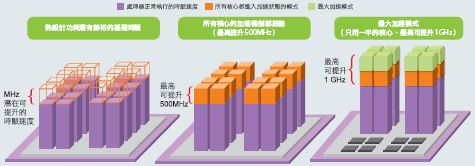

| 在2011年11月,AMD推出了新一代伺服器專用,代號為Interlagos的Opteron 6200與4200系列處理器,接續先前的Opteron 6100及4100系列,並且一舉將最高的內含核心數增加到16核心。 除了Opteron 6200與4200系列之外,AMD在3月20日發表3款代號為Zurich 的Opteron 3200系列,主要針對微型伺服器、網站主機代管與網路伺服器等低功耗需求。這系列處理器也和上述Opteron處理器一樣,繼續採用Bulldozer架構,而且內建8或4核心,但處理器插槽是AMD在桌上型電腦處理器所採用的AM3+規格。 處理器全面使用32奈米製程,並採用Bulldozer核心架構 在核心架構上,新一代Opteron系列處理器最大的改變,就是Bulldozer核心架構,並且將製程從45奈米提高為32奈米,而且增加處理器核心數量的同時,也延續、加強前一代所擁有的HyperTransport,並新增動態超頻技術Turbo Core。在採用的插槽上,Opteron 6200系列處理器採用G34規格,而4200系列則採用C32規格,而採用G34插槽的6200系列處理器,在外觀上呈現特殊的長方形,而不是一般常見的正方形。 而主機板相容性部分,從上一代Opteron 6100與4100開始,就開始各自使用G34與C32處理器插槽,因此即使是採用上述處理器的伺服器,換CPU後可以直接升級,且根據AMD的規畫,目前這些插槽規格,會延續使用到下一代採用Piledriver核心架構的處理器,所以這段期間並不會因為採用不同的處理器插槽,讓伺服器無法升級。 Bulldozer核心架構 在新的Bulldozer核心架構下,每個處理器核心模組都內建兩個擁有獨立L1快取記憶體的整數運算核心,以及與浮點運算排程器(使用2個128位元乘法累加器),並共用讀取器、編譯器與L2快取記憶體,而L3快取記憶體是由整顆處理器共用。  AMD伺服器平臺處理器推出規畫(2012-2013) 在AMD規畫的下一代伺服器處理器,依然採用G34、C32與AM3+的處理器插槽,並採用Piledriver核心架構,現有的Bulldozer核心架構的伺服器不必擔心升級的問題,另外還新增針對網頁代管以及微型伺服器架構的Opteron 3000系列。  產品定位涵蓋範圍廣,選擇較單純 在AMD 的Opteron處理器定位中,4000系列向來是針對單路與2路伺服器所搭配的處理器,而6000系列則使用於2路與4路伺服器,而最新發表的3200系列則是單路,但主打的是低功耗的環境,這和Intel Xeon推出E3、E5與E7等系列處理器的分類方式不大相同。 如果將Opteron 6000系列與Intel Xeon E7相提並論,或許是比較恰當的,因為它們同樣都支援2路與4路伺服器的架構。不過,Xeon E7系列處理器在配置上,若要將它們安裝在2路或4路的伺服器上,必須選用針對2路或以上規格的處理器,也就是說必須選擇更高規的處理器,例如E7-2860就只能用在2路,E7-4820就可以用在4路以及2路的架構(4插槽僅安裝2顆處理器),而Opteron 6200系列沒有這種限制,因為全系列都支援4路架構,也同樣可向下相容2路、甚至單路架構,也就是同型號的處理器不論是裝2顆或4顆都可以,不必特定選用針對2路或4路架構的處理器。 在價格部分,較便宜一直都是AMD處理器的特色,根據去年發表時的價格,Opteron 6200與4200處理器中最高階、價位最貴為6282 SE,每千顆單位的報價為1,019美元,這樣的價格在Intel Xeon E5處理器中,僅有E5-2650與E5-2650L,或是更低階的處理器價格,才會接近,或低於這顆處理器。而Xeon E7處理器中,更是僅有2路的E7-2803與4路的E7-4807售價低於Opteron 6282 SE。從這結果可看出AMD Opteron處理器的價格相較於Intel Xeon處理器相對便宜許多。 綜觀伺服器廠商的產品型號與規格,可看出目前採用AMD Opteron 6200或4200處理器的產品數量,遠少於Intel Xeon系列伺服器,例如HP的20款機架式伺服器系列中,僅有6款採用AMD處理器的產品,而Dell的22款機架式伺服器中,僅有6款採用AMD Opteorn處理器,而直立式伺服器則是付之闕如。有些廠商僅推出採用Intel Xeon處理器平臺的機種,並沒有任何AMD平臺的產品(如NEC),不難看出,目前處理器市場的主流處理器平臺仍然是Intel。 最多內建16個實體核心 在這一代採用Bulldozer核心架構的AMD Opteron系列處理器,最主要的改變,就是實體核心數量的增加。 在Opteron 6100系列中,處理器內建核心數量為8核心和12核心,而4100系列處理器是4核心和6核心,到了現在,採用Bulldozer核心架構的Opteron 6200系列處理器,核心數最多16核心,且另外還有4、8、12核心的選擇,而4200系列最多到8核心。 與Intel Xeon處理器相比,「實體」核心數量較多,一直是AMD Opteron處理器所強調的,舉例來說,Intel Xeon上一代處理器中,主打2路伺服器的5600系列處理器,最多只有實體4核心與6核心。 雖然Intel在目前最新的Xeon E7系列處理器中,最高擁有10核心,且有超執行緒(Hyper Threading)使每個實體核心模擬為兩個虛擬核心,讓作業系統可運用到更多的核心,例如在2路伺服器架構下,搭配2顆4核心的處理器,你的系統就有16個運算核心,但AMD Opteron則是實體核心就可達到這個數量。 另一方面,目前Intel Xeon E7處理器中,最多擁有10核心,加上超執行緒技術,每顆處理器一共有20個執行緒,雖然同時可處理的執行緒數量上比AMD Opteron 6200系列的16核心處理器還多,不過內建10核心的處理器僅限4路以上的伺服器架構,例如E7-4850或4860以上,而AMD Opteron 6200在2路伺服器即可採用。 就時脈而言,比較特別的,是主打2路與4路的Opteron 6200系列處理器中,有一顆僅有4核心且沒有Turbo Core超頻技術的6204,雖然以這規格來看,這顆處理器規格較低,但是它的基礎時脈高達3.3GHz,居所有Opteron 6200系列處理之冠。 在I/O方面,AMD Opteron處理器從上一代6100系列開始,即採用了HyperTransport 3.1的技術,讓處理器與處理器之間可直接產生連結溝通(Direct Connect Architecture),且當中的傳輸速度達6.4GT/s。 近來因為虛擬化的需求與日漸提升,伺服器對記憶體的需求也越來越高,尤其是記憶體總容量的需求。 對AMD Opteron 6200而言,在記憶體容量的支援上,每顆處理器都可對應256GB,例如2路伺服器可支援24支記憶體(512GB),而4路伺服器的話,則可安裝32支記憶體(1TB)。另外,新一代的Opteron 6200系列處理器也繼續支援4條記憶體通道的存取方式、新支援DDR3 1600MHz的記憶體規格。 1個Bulldozer模組內建2個整數運算核心 新的Bulldozer架構與以往處理器設計的方式有很大不同,那就是它將兩個整數運算核心合併,而且這兩個核心共用一些編譯器(Decode)與讀取器(Fetch),同時共用一個浮點運算排程器(FP Scheduler)整合在同一個模組中。以16核心的Opteron而言,實際上是以8個Bulldozer所組成。 AMD認為,這種架構的好處,是在多執行緒的狀態下,可以使每個核心分別運算,並且在L2快取記憶體的部份共用運算結果,加快運算的速度。 除了前面提到的整數運算、浮點運算,以及提高處理器核心時時脈的Turbo Core技術之外,採用Bulldozer核心架構的Opteron系列處理器,也將多種常見的指令集內建其中,例如SSE4.1、SSE4.2、SSSE3等編碼標準,以及先進向量擴充指令集(AVX)與進階加密標準指令集(AES)等。 首度加入動態超頻技術 在時脈超頻的技術上,Bulldozer架構採用的是AMD 第二代的Turbo Core的技術,第一代Turbo Core技術首次出現在AMD產品,是在桌上型電腦處理器Phenom II X6上。這種超頻的方式和Intel的Turbo Boost類似,同樣可以動態調節核心的頻率,適合需要執行緒較少,但是需要高時脈來加速運算的工作。 AMD新一代核心超頻技術Turbo Core AMD Turbo Core超頻技術,讓處理器可依工作內容與負載,動態調整全部核心的運作狀態,並可在特定需要高時脈工作的狀態下,降低部分核心,提高其餘核心的時脈。  而Turbo Core的處理器頻率,變化分為3階段:所有核心都運作在基礎時脈上、所有核心加速機制都啟動的狀態,以及部分核心最大加速機制啟動。 在一般狀態下,所有的處理器核心都只運作在基礎時脈上,而這種狀態下處理器的熱設計功耗(TDP)都還有餘裕。第二種是所有核心的加速機制都啟動的狀態,每個核心的時脈速度可提高300MHz到500MHz,而TDP已經處於最高負載狀態;第三種為最大加速模式,則是讓部分核心的時脈速再提升,最高可提高1GHz,其餘核心則是處於待機狀態。 看起來和Intel Turbo Boost有些類似,但是AMD Turbo Core在超頻時,僅能集中在一半的核心上,也就是如果是16核心處理器,在最大加速模式下,可以讓8個核心的時脈速度提高,不像Intel Turbo Boost2.0可集中在單一核心上,而且很可惜的是其他核心僅處於低速狀態,無法完全關閉,因此仍會有因運作而產生的耗能。反觀Turbo Boost在超頻時,可以集中在部分,甚至單一核心時脈上,而其他核心則處於關閉狀態。 整體而言,AMD的Turbo Core在運用彈性與效能供應上,都還有進步的空間。文⊙林柏凱 2012 AMD最新Opteron處理器的規格

|

星期二, 4月 24, 2012

Dell併Wyse Wyse在臺市占超過4成

| Dell併Wyse,奪Thin Client龍頭 | ||||

| ||||

| Dell併購精簡型電腦廠商Wyse後,企業期待Dell推出全套桌面虛擬化方案 | ||||

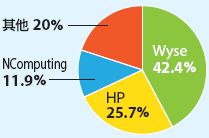

| 日前Dell併購臺灣市占第一的精簡型電腦(Thin Client)廠商Wyse,補足Dell桌面虛擬化方案在終端設備的缺口。Dell原本就有銷售精簡型電腦,但產品種類較少,這次併購了Wyse之後,預計將納入Wyse旗下針對大量精簡型裝置的管理軟體、桌面虛擬化軟體、網路傳輸優化的產品、精簡型電腦,以及Wyse在全球的經銷通路等。 企業規畫虛擬桌面架構(Virtual Desktop Infrastructure,VDI)的同時,還必須調整後端機房的系統架構。如今Dell併購Wyse之後,可搭配Dell資料中心的產品,推出整套桌面虛擬化解決方案。 華泰電子企業資訊管理部資訊長王金秋表示,透過近幾年的併購案,Dell後端基礎架構的產品線更完整,涵蓋伺服器、儲存與網通設備等產品,不過,精簡型電腦的產品相對較少,仍以銷售個人電腦為主,透過併購Wyse,可望補足Dell這一塊的產品線,提供企業一站購足的解決方案。 例如,華泰電子採用Dell伺服器安裝VMware View桌面虛擬化軟體,搭配Wyse精簡型電腦,來建構公司的VDI架構,待未來兩家廠商的銷售通路合併後,華泰電子希望能以更優惠的價格,一次買齊桌面虛擬化從後端到終端的整套解決方案。另一方面,華泰電子還期待,未來Dell與Wyse兩家產品技術能夠進一步整合,來改善後端系統與精簡型電腦之間的管理與傳輸技術。 臺灣IDC針對2011年精簡型電腦市場各廠牌營收市占率的調查顯示,Wyse以42.4%市占率奪冠,HP則以25.7%市占居後,第三名則是市占11.9%的NComputing,其餘2成市占則由眾多廠商瓜分,包括Dell、ASUS、聯想等,如今Dell併購Wyse後,將晉身精簡型電腦市占第一的寶座。 臺灣IDC伺服器與儲存分析師高振偉表示,由於台積電新廠的終端設備大多採用Wyse精簡型電腦,帶動上下游產業跟著採用,導致Wyse共有8~9成的臺灣企業用戶都是製造業,這次Dell併購Wyse後,若能推出整套方案,將利於這些企業擴大導入。文⊙鄭逸寧  Wyse在臺市占超過4成 Wyse在臺市占超過4成臺灣IDC針對2011年精簡型電腦廠牌營收市占調查顯示,Wyse以超過4成的市占率奪冠,居次的HP也只有2成5市占。 |

星期一, 4月 02, 2012

Google彰濱工業園區30億元台幣資料中心4月3日動土

工商時報【記者何英煒╱台北報導】

Google評估多年、去年9月正式宣布要在台灣的彰濱工業園區,投資一億美元(約30億元台幣),興建大型資料中心,確定將於4月3日動土。Google表示,該資料中心將透過最新技術為台灣等亞洲網路用戶提供服務,而台灣也成為 Google的重要據點。

明日動土典禮在彰濱工業園區舉行,Google亞太區總裁Daniel Alegre和Google台灣董事總經理簡立峰將與政府部會首長,共同揭示該資料中心最新發展與計畫,並分享Google在台深耕計畫與重要里程。

而外電也報導Google本週可望正式宣布推出雲端儲存Google Drive服務。法人表示,相關雲端概念股可望成為本週股市亮點。

Google去年9月份宣布在新加坡、香港及台灣成立大型資料中心。其中台灣的資料中心將斥資一億美元,並且已經在彰濱工業園區購地15公頃。

法人表示,Google在全球各地興建大型資料中心,有助於台灣相關上游供應商的出貨。目前台灣的伺服器廠商及磁碟陣列業者,為Google資料中心的供應商,包括伺服器硬體產品為主的廣達、神達、緯創、英業達、鴻海等。

因應資料中心龐大的儲存空間需求,磁碟陣列業者也是值得關注的族群,包括,喬鼎、普安、世仰等,也都是Google資料中心的上游供應商。Google今年在亞太區的三大資料中心陸續動工興建,並在明年啟用,法人表示,上游業者的出貨可以被期待。

除了在全球各地興建資料中心外,外電則是報導,繼蘋果推出雲端服務iCloud之後,Google本週也會推出雲端儲存Google Drive的服務,外電報導Google將提供消費者5GB的網路免費儲存空間。

可以預見,Google、蘋果等國際大廠力推雲端服務,未來對於資料中心的需求量也會愈來愈大。對台灣上游相關供應鏈來說,包括伺服器、磁碟陣列、以及網通、機構件等需求也會愈來愈多。法人表示,雖然近期台股有不確定的政策因素,但雲端概念股長期來看是值得逢低布局的族群。

星期四, 3月 29, 2012

一個值得學習的觀念 臺灣菸酒總經理林讚峰

| 臺灣菸酒總經理林讚峰:CEO也要逼自己學IT | ||||

| ||||

| 臺灣菸酒從2009年開始斥資2億元在全臺上百據點導入SAP ERP,這個專案就是由臺灣菸酒總經理林讚峰所提議,而他認為,「導入ERP對臺灣菸酒最大的幫助是提高銷售端資料的透明度,以及管理銷售據點。」 | ||||

臺灣菸酒從2009年開始斥資2億元在全臺上百據點導入SAP ERP,這個專案就是由臺灣菸酒總經理林讚峰所提議,而他認為,「導入ERP對臺灣菸酒最大的幫助是提高銷售端資料的透明度,以及管理銷售據點。」 這並不意味臺灣菸酒不在意生產端的管理,林讚峰表示,相對銷售端,臺灣菸酒生產端的流程單純許多,對資料和數據需求的急迫性也沒有銷售端來的高,除此之外,林讚峰對於臺灣菸酒所生產出來的產品有很高的信心,但,「現在這個時代,不是產品做得好就好,重要的是,要怎麼賣。」 這個觀念對臺灣菸酒來說,其實是很大的轉變。你很難想像,20年前,在臺灣菸酒還是臺灣省菸酒公賣局時,一個酒廠或是菸廠的廠長,必須具有公務人員簡任官職等,相當於地方政府最高職等的事務官位階,權力以及影響力可見一斑。不難想見,過去生產單位在臺灣菸酒是如何受到重視。不過,隨著臺灣菸酒公賣局改制成為臺灣菸酒公司,情況開始有所轉變,銷售端的重要性也與日俱增。 在CEO眼中,導入ERP的最終目的是幫助銷售,不是生產 臺灣菸酒有很複雜的通路體系,從大賣場、零售商、海產店、夜店等,都是通路商。過去,臺灣菸酒在全臺各地都設有營業所,再由這些營業所配銷產品給銷售據點,累積至今,臺灣菸酒現在總共擁有4萬多個銷售商。 這些為數甚多的銷售商,過去都由各個營業所負責管理,各自業務管理上的資料格式、表單設計和工作流程,通通都不一樣,因此也難以彙整,換句話說,總部想要掌握即時資訊根本是不可能的事情。 臺灣菸酒公司化以後,經營心態也跟著公司化。「導入ERP就是要增強我們的戰鬥力。」林讚峰認為,導入ERP的第一步就是要先統一資料,才能有即時反應的能力。 林讚峰說了一件很有意思的例子,啤酒的重量重、利潤低,再加上有產品品質責任歸屬的考量,北部廠生產的酒不可以到北部以外的地方販售,中部、南部廠所生產的酒也是如此。因此,各地酒廠就負責生產當地所需要的產品數量,過往,臺灣菸酒都是根據歷史資料來推估各廠生產數量。 不過,啤酒需要量其實跟氣溫有很大的關係。所以像是臺灣頭與臺灣尾,冬天啤酒的銷量可以差到3倍之多,就是受到氣溫的影響,導致臺中以北的人在冬天喝啤酒的量會大幅減少,因此不同的酒廠,在冬天的忙碌程度也不一樣。 麻煩的是,氣溫年年都會變化,林讚峰表示,用歷史資料來推估總會有誤差,導致每座工廠來不及因應市場的銷售。比如說,今年南部冬天的氣溫特別低,若只依照過往資料來生產,就造成生產過剩的問題。「這都是因為沒有辦法收集最新市場端的即時資訊,並依據正確資料反應。」 因此,林讚峰希望臺灣菸酒對銷售端資料的反應速度,「要做到像7-11的反應一樣,產品一賣完,補貨就到,不能有時間差。」這些,林讚峰都打算靠ERP來完成。 用資訊系統來跟其他世界大廠競爭 臺灣菸酒不是第一個導ERP的國營事業導,論規模,也不是最大的,可是,臺灣菸酒的業務性質肯定是最複雜,不僅跨越生產銷售,更重要的是,不同於其他國營事業通常經營的是獨占事業,「臺灣菸酒不僅要面對眾多競爭者,而且,競爭者是來自世界各地的廠商。」林讚峰說。 談到與世界競爭,林讚峰倒是很感慨,因為臺灣的菸廠中有三座,除了生產臺灣菸酒自營商品之外,還分別各自代工日本、英國、美國知名品牌菸廠的菸,令他吃驚的是,這三個不同國家菸廠資訊流的相似度,比臺灣自己三座菸廠的同質性還高。林讚峰認為,這是因為國際菸廠藉由資訊系統建立了標準化的流程。「所以,國際菸廠在全世界都可以清楚掌握當地市場對菸價的反應,並且隨時依銷售數據調整售價,跟他們一比,難怪我們的市占率年年下滑。」 對林讚峰來說,市占率下滑是事實,但國際廠商藉由資訊系統提供正確即時數據來協助企業營運決策的能力,讓他了解資訊系統對企業營運的重要性,也讓他在經營管理的路上特別重視資訊系統。 聽林讚峰談資訊系統,一時之間你會以為自己是跟一位從CIO升任CEO的人聊天,但是,林讚峰擁有的是美國麻省理工學院生化工程博士的學位,更是個紅?專家,一路求學就業之路,沒有任何IT的背景。 「我要逼別人,得先逼自己」林讚峰說。在這個轉型中的國營單位要推動資訊化改革,其中的難度外人很難想像,身為總經理的他,如果想輕鬆點,大可以把事情全交辦下去即可,可是,他把自己定位為「全方位問題解決者。」有問題,他一定跳下去解決,「我一定要跳下去跟大家玩一玩。」因為,這種跨部門的專案若是沒有總經理的角色跳下來玩一玩,肯定就無法順利推動。 很難,但還是很積極的學。這就是一個想要以資訊系統改造企業的CEO,所具有的態度。文⊙辜雅蕾 |

星期二, 3月 27, 2012

Internet Small Computer System Interface (iSCSI)

In computing, iSCSI ( i/aɪˈskʌzi/ eye-skuz-ee), is an abbreviation of Internet Small Computer System Interface, an Internet Protocol (IP)-based storage networking standard for linking data storage facilities. By carrying SCSI commands over IP networks, iSCSI is used to facilitate data transfers over intranets and to manage storage over long distances. iSCSI can be used to transmit data over local area networks (LANs), wide area networks (WANs), or the Internet and can enable location-independent data storage and retrieval. The protocol allows clients (called initiators) to send SCSI commands (CDBs) to SCSI storage devices (targets) on remote servers. It is a Storage Area Network (SAN) protocol, allowing organizations to consolidate storage into data center storage arrays while providing hosts (such as database and web servers) with the illusion of locally-attached disks. Unlike traditional Fibre Channel, which requires special-purpose cabling, iSCSI can be run over long distances using existing network infrastructure.

i/aɪˈskʌzi/ eye-skuz-ee), is an abbreviation of Internet Small Computer System Interface, an Internet Protocol (IP)-based storage networking standard for linking data storage facilities. By carrying SCSI commands over IP networks, iSCSI is used to facilitate data transfers over intranets and to manage storage over long distances. iSCSI can be used to transmit data over local area networks (LANs), wide area networks (WANs), or the Internet and can enable location-independent data storage and retrieval. The protocol allows clients (called initiators) to send SCSI commands (CDBs) to SCSI storage devices (targets) on remote servers. It is a Storage Area Network (SAN) protocol, allowing organizations to consolidate storage into data center storage arrays while providing hosts (such as database and web servers) with the illusion of locally-attached disks. Unlike traditional Fibre Channel, which requires special-purpose cabling, iSCSI can be run over long distances using existing network infrastructure.

Functionality

iSCSI uses TCP/IP (typically TCP ports 860 and 3260). In essence, iSCSI simply allows two hosts to negotiate and then exchange SCSI commands using IP networks. By doing this iSCSI takes a popular high-performance local storage bus and emulates it over wide-area networks, creating a storage area network (SAN). Unlike some SAN protocols, iSCSI requires no dedicated cabling; it can be run over existing switching and IP infrastructure. As a result, iSCSI is often seen as a low-cost alternative to Fibre Channel, which requires dedicated infrastructure except in its FCoE (Fibre Channel over Ethernet) form. However, the performance of an iSCSI SAN deployment can be severely degraded if not operated on a dedicated network or subnet (LAN or VLAN).

Although iSCSI can communicate with arbitrary types of SCSI devices, system administrators almost always use it to allow server computers (such as database servers) to access disk volumes on storage arrays. iSCSI SANs often have one of two objectives:

- Storage consolidation

- Organizations move disparate storage resources from servers around their network to central locations, often in data centers; this allows for more efficiency in the allocation of storage. In a SAN environment, a server can be allocated a new disk volume without any change to hardware or cabling.

- Disaster recovery

- Organizations mirror storage resources from one data center to a remote data center, which can serve as a hot standby in the event of a prolonged outage. In particular, iSCSI SANs allow entire disk arrays to be migrated across a WAN with minimal configuration changes, in effect making storage "routable" in the same manner as network traffic.

[edit]Network booting

For general data storage on an already-booted computer, any type of generic network interface may be used to access iSCSI devices. However, a generic consumer-grade network interface is not able to boot a diskless computer from a remote iSCSI data source. Instead it is commonplace for a server to load its initial operating system from a TFTP server or local boot device, and then use iSCSI for data storage once booting from the local device has finished.

A separate DHCP server may be configured to assist interfaces equipped with network boot capability to be able to boot over iSCSI. In this case the network interface looks for a DHCP server offering a PXE or bootp boot image. This is used to kick off the iSCSI remote boot process, using the booting network interface's MAC address to direct the computer to the correct iSCSI boot target.

Most Intel Ethernet controllers for servers support iSCSI boot. [1]

Network switch 網路交換器的功能種類

Network switch

From Wikipedia, the free encyclopedia

A network switch or switching hub is a computer networking device that connects network segments or network devices. The term commonly refers to a multi-port network bridge that processes and routes data at the data link layer (layer 2) of the OSI model. Switches that additionally process data at thenetwork layer (layer 3) and above are often referred to as layer-3 switches or multilayer switches.

A switch is a telecommunication device which receives a message from any device connected to it and then transmits the message only to that device for which the message was meant. This makes the switch a more intelligent device than hub (which receives a message and then transmits it to all the other devices on its network.) The network switch plays an integral part in most modern Ethernetlocal area networks (LANs). Mid-to-large sized LANs contain a number of linked managed switches. Small office/home office (SOHO) applications typically use a single switch, or an all-purposeconverged device such as a residential gateway to access small office/home broadband services such as DSL or cable internet. In most of these cases, the end-user device contains a router and components that interface to the particular physical broadband technology. User devices may also include a telephone interface for VoIP.[edit]Function

An Ethernet switch operates at the data link layer of the OSI model to create a separate collision domain for each switch port. With 4 computers (e.g., A, B, C, and D) on 4 switch ports, A and B can transfer data back and forth, while C and D also do so simultaneously, and the two conversations will not interfere with one another. In the case of a hub, they would all share the bandwidth and run inhalf duplex, resulting in collisions, which would then necessitate retransmissions. Using a switch is called microsegmentation. This allows computers to have dedicated bandwidth on a point-to-point connections to the network and to therefore run in full duplex without collisions.

[edit]Role of switches in networks

Switches may operate at one or more layers of the OSI model, including data link and network. A device that operates simultaneously at more than one of these layers is known as a multilayer switch.

In switches intended for commercial use, built-in or modular interfaces make it possible to connect different types of networks, including Ethernet, Fibre Channel, ATM, ITU-T G.hn and 802.11. This connectivity can be at any of the layers mentioned. While layer-2 functionality is adequate for bandwidth-shifting within one technology, interconnecting technologies such as Ethernet and token ring is easier at layer 3.

Devices that interconnect at layer 3 are traditionally called routers, so layer-3 switches can also be regarded as (relatively primitive) routers.

In some service provider and other environments where there is a need for a great deal of analysis of network performance and security, switches may be connected between WAN routers as places for analytic modules. Some vendors provide firewall,[2][3] network intrusion detection,[4] and performance analysis modules that can plug into switch ports. Some of these functions may be on combined modules.[5]

In other cases, the switch is used to create a mirror image of data that can go to an external device. Since most switch port mirroring provides only one mirrored stream, network hubs can be useful for fanning out data to several read-only analyzers, such as intrusion detection systems and packet sniffers.

[edit]Layer-specific functionality

Main article: Multilayer switch

While switches may learn about topologies at many layers, and forward at one or more layers, they do tend to have common features. Other than for high-performance applications, modern commercial switches use primarily Ethernet interfaces.

At any layer, a modern switch may implement power over Ethernet (PoE), which avoids the need for attached devices, such as a VoIP phone or wireless access point, to have a separate power supply. Since switches can have redundant power circuits connected to uninterruptible power supplies, the connected device can continue operating even when regular office power fails.

[edit]Layer 1 hubs versus higher-layer switches

A network hub, or repeater, is a simple network device. Hubs do not manage any of the traffic that comes through them. Any packet entering a port is broadcast out or "repeated" on every other port, except for the port of entry. Since every packet is repeated on every other port, packet collisions affect the entire network, limiting its capacity.

There are specialized applications where a hub can be useful, such as copying traffic to multiple network sensors. High end switches have a feature which does the same thing called port mirroring.

By the early 2000s, there was little price difference between a hub and a low-end switch.[6]

[edit]Layer 2

A network bridge, operating at the data link layer, may interconnect a small number of devices in a home or the office. This is a trivial case of bridging, in which the bridge learns the MAC address of each connected device.

Single bridges also can provide extremely high performance in specialized applications such as storage area networks.

Classic bridges may also interconnect using a spanning tree protocol that disables links so that the resulting local area network is a tree without loops. In contrast to routers, spanning tree bridges must have topologies with only one active path between two points. The older IEEE 802.1D spanning tree protocol could be quite slow, with forwarding stopping for 30 seconds while the spanning tree would reconverge. A Rapid Spanning Tree Protocol was introduced as IEEE 802.1w, but the newest edition of IEEE 802.1D adopts the 802.1w extensions as the base standard.

The IETF is specifying the TRILL protocol, which is the application of link-state routing technology to the layer-2 bridging problem. Devices which implement TRILL, called RBridges, combine the best features of both routers and bridges.

While layer 2 switch remains more of a marketing term than a technical term,[citation needed] the products that were introduced as "switches" tended to use microsegmentation and Full duplex to prevent collisions among devices connected to Ethernet. By using an internal forwarding plane much faster than any interface, they give the impression of simultaneous paths among multiple devices.

Once a bridge learns the topology through a spanning tree protocol, it forwards data link layer frames using a layer 2 forwarding method. There are four forwarding methods a bridge can use, of which the second through fourth method were performance-increasing methods when used on "switch" products with the same input and output port bandwidths:

- Store and forward: The switch buffers and verifies each frame before forwarding it.

- Cut through: The switch reads only up to the frame's hardware address before starting to forward it. Cut-through switches have to fall back to store and forward if the outgoing port is busy at the time the packet arrives. There is no error checking with this method.

- Fragment free: A method that attempts to retain the benefits of both store and forward and cut through. Fragment free checks the first 64 bytes of the frame, where addressing information is stored. According to Ethernet specifications, collisions should be detected during the first 64 bytes of the frame, so frames that are in error because of a collision will not be forwarded. This way the frame will always reach its intended destination. Error checking of the actual data in the packet is left for the end device.

- Adaptive switching: A method of automatically selecting between the other three modes.

While there are specialized applications, such as storage area networks, where the input and output interfaces are the same bandwidth, this is not always the case in general LAN applications. In LANs, a switch used for end user access typically concentrates lower bandwidth and uplinks into a higher bandwidth.

[edit]Layer 3

Within the confines of the Ethernet physical layer, a layer-3 switch can perform some or all of the functions normally performed by a router. The most common layer-3 capability is awareness of IP multicast through IGMP snooping. With this awareness, a layer-3 switch can increase efficiency by delivering the traffic of a multicast group only to ports where the attached device has signaled that it wants to listen to that group.

[edit]Layer 4

While the exact meaning of the term layer-4 switch is vendor-dependent, it almost always starts with a capability for network address translation, but then adds some type of load distribution based onTCP sessions.[7]

[edit]Layer 7

Layer-7 switches may distribute loads based on Uniform Resource Locator URL or by some installation-specific technique to recognize application-level transactions. A layer-7 switch may include aweb cache and participate in a content delivery network.[8]

訂閱:

文章 (Atom)